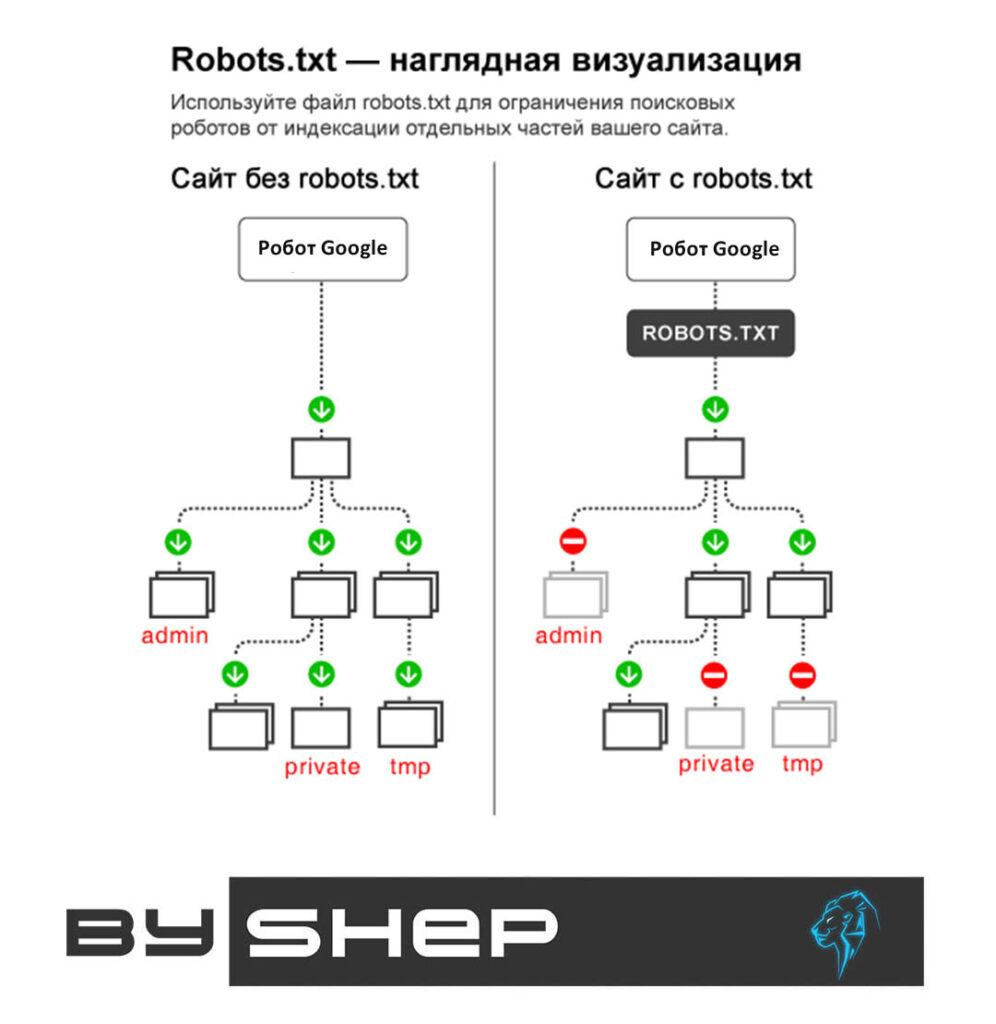

Robots.txt – известен, как текстовый файл, где указаны правила индексации сайта для роботов поисковиков. Такие поисковые системы, как Яндекс и Google постоянно осуществляют загрузку документа с сервера, когда анализируют веб-ресурсы. В нем есть директивы, при помощи которых можно открыть или закрыть доступ поисковым системам к информации на сайте.

Как создать и настроить robots.txt?

Файловый документ проще всего сделать в стандартном текстовом редакторе. Директивы уведомляют робота, какой контент подлежит индексированию, а какой нет. Не рекомендовано прибегать к использованию автогенератора для создания документа, что может привести к негативным последствиям при индексации ресурса и его продвижении.

Инструкция по применению директив в файле robots.txt

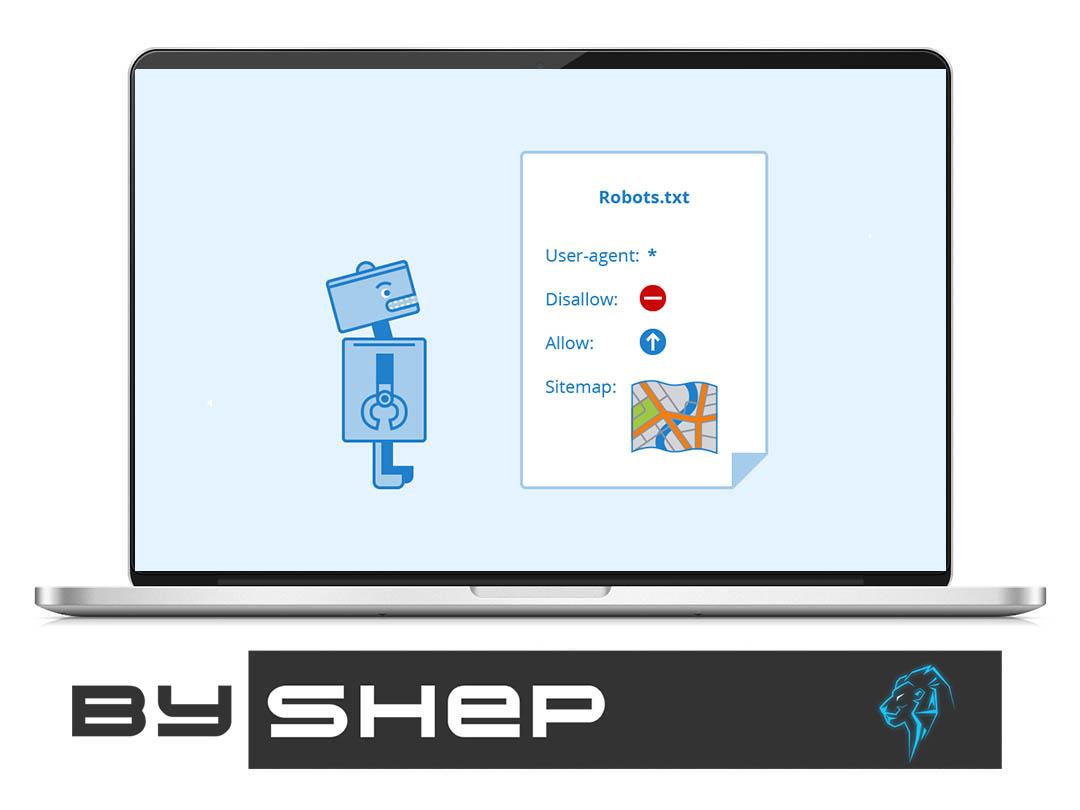

User-agent – запись для указания на робота при индексировании.

Disallow. Запрещающая директива не допускает к индексации каталоги или страницы ресурсов.

Allow. Разрешающая – полностью противоположная предыдущей.

Sitemap. Дает информацию поисковику о геолокации файла карты сайта.

Clean-param. Уведомляет робота о наличии на сайте параметров, которые нужно учесть при обращении к файлу. У одной страницы, может быть, несколько активных ссылок, робот не должен принять их за дубляж контента.

Crawl-delay. Запускает загрузку с одной страницы на другую за минимальный временной отрезок, что актуально для слабых серверов.

Как провести анализ файла robots.txt.

Чтобы удостовериться в правильности создания документа, можно проверить его в панели вебмастера поисковика, используя специальную ссылку. Согласно результатам анализа будут отображены допуск или запрет на индексацию определенных страниц.

Пример файла robot.txt для WordPress и его визуализация

Версия 1 (не строгая)

User-agent: * # Создаем секцию правил для роботов. * значит для всех # роботов. Чтобы указать секцию правил для отдельного

# робота, вместо * укажите его имя: GoogleBot

Disallow: /cgi-bin # Стандартная папка на хостинге.

Disallow: /wp-admin/ # Закрываем админку.

Disallow: /? # Все параметры запроса на главной.

Disallow: *?s= # Поиск.

Disallow: *&s= # Поиск.

Disallow: /search # Поиск.

Disallow: /author/ # Архив автора.

Disallow: */embed$ # Все встраивания.

Disallow: */page/ # Все виды пагинации.

Disallow: */xmlrpc.php # Файл WordPress API

Disallow: *utm*= # Ссылки с utm-метками

Disallow: *openstat= # Ссылки с метками openstat

# Одина или несколько ссылок на карту сайта (файл Sitemap). Это независимая

# директива и дублировать её для каждого User-agent не нужно. Так например # Google XML Sitemap создает 2 карты сайта:

Sitemap: http://example.com/sitemap.xml

Sitemap: http://example.com/sitemap.xml.gz

# Версия кода: 2.0

# Не забудьте поменять `example.com` на ваш сайт.Версия 2 (строгая)

User-agent: * # Создаем секцию правил для роботов. * значит для всех

# роботов. Чтобы указать секцию правил для отдельного

# робота, вместо * укажите его имя: GoogleBot, Yandex.

Disallow: /cgi-bin # Стандартная папка на хостинге.

Disallow: /wp- # Все связанное с WP - это: /wp-content /wp-admin

# /wp-includes /wp-json wp-login.php wp-register.php.

Disallow: /wp/ # Каталог куда установлено ядро WP (если ядро установлено

# в подкаталог). Если WP установлен стандартно, то

# правило можно удалить.

Disallow: /? # Все параметры запроса на главной.

Disallow: *?s= # Поиск.

Disallow: *&s= # Поиск.

Disallow: /search # Поиск.

Disallow: /author/ # Архив автора.

Disallow: */embed$ # Все встраивания.

Disallow: */page/ # Все виды пагинации.

Disallow: */xmlrpc.php # Файл WordPress API

Disallow: *utm*= # Ссылки с utm-метками

Disallow: *openstat= # Ссылки с метками openstat

Allow: */wp-*/*ajax*.php # AJAX запросы: */admin-ajax.php */front-ajaxs.php

Allow: */wp-sitemap # карта сайта (главная и вложенные)

Allow: */uploads # открываем uploads

Allow: */wp-*/*.js # внутри /wp- (/*/ - для приоритета)

Allow: */wp-*/*.css # внутри /wp- (/*/ - для приоритета)

Allow: */wp-*/*.png # картинки в плагинах, cache папке и т.д.

Allow: */wp-*/*.jpg # картинки в плагинах, cache папке и т.д.

Allow: */wp-*/*.jpeg # картинки в плагинах, cache папке и т.д.

Allow: */wp-*/*.gif # картинки в плагинах, cache папке и т.д.

Allow: */wp-*/*.svg # картинки в плагинах, cache папке и т.д.

Allow: */wp-*/*.webp # файлы в плагинах, cache папке и т.д.

Allow: */wp-*/*.swf # файлы в плагинах, cache папке и т.д.

Allow: */wp-*/*.pdf # файлы в плагинах, cache папке и т.д.

# Секция правил закончена

# Одна или несколько ссылок на карту сайта (файл Sitemap). Это независимая

# директива и дублировать её для каждого User-agent не нужно. Так например

# Google XML Sitemap создает 2 карты сайта:

Sitemap: http://example.com/wp-sitemap.xml

Sitemap: http://example.com/wp-sitemap.xml.gz

# Версия кода: 2.0

# Не забудьте поменять `example.com` на ваш сайт.Этот код я пожалуй не рекомендовал бы, потому что тут закрывается все от

wp-и нужно будет описать все что разрешено. Так в будущем, когда WP введет что-то новое, это новое может стать недоступно для роботов.