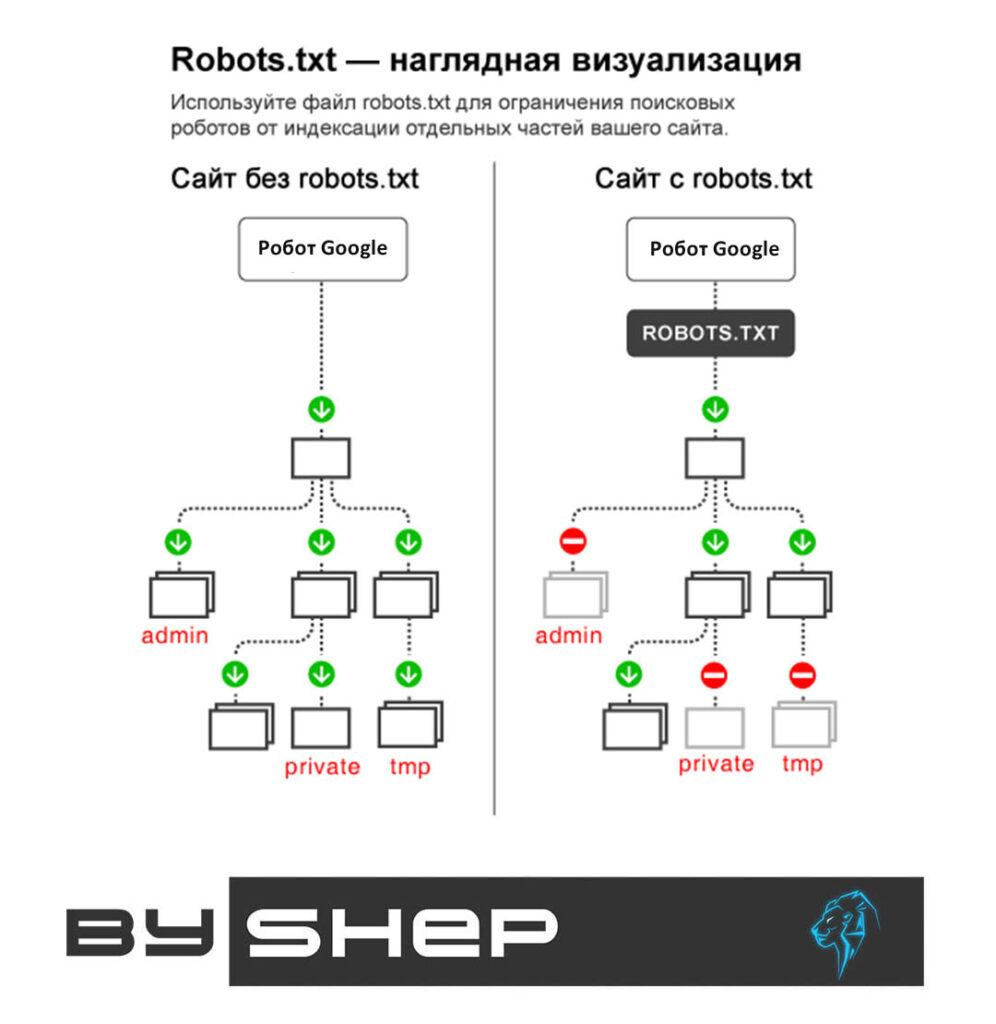

Robots.txt – відомий як текстовий файл, де вказані правила індексації сайту для роботів пошукових систем. Такі пошукові системи, як Яндекс і Google, постійно здійснюють завантаження документа з сервера, коли аналізують веб-ресурси. У ньому є директиви, за допомогою яких можна відкрити або закрити доступ до пошукових систем до інформації на сайті.

Як створити та налаштувати robots.txt?

Файловий документ найпростіше зробити у стандартному текстовому редакторі. Директиви повідомляють робота, який контент підлягає індексуванню, а який ні. Не рекомендується використовувати автогенератор для створення документа, що може призвести до негативних наслідків при індексації ресурсу та його просуванні.

Інструкція із застосування директив у файлі robots.txt

User-agent – запис для вказівки на робота при індексуванні. Disallow. Забороняюча директива не допускає до індексації каталогів або сторінок ресурсів. Allow. Дозволяюча – повністю протилежна до попередньої. Sitemap. Дає інформацію пошуковику про геолокацію файлу картки сайту. Clean-param. Повідомляє робота про наявність на сайті параметрів, які потрібно врахувати під час звернення до файлу. В однієї сторінки, можливо, кілька активних посилань, робот повинен прийняти їх за дубляж контенту. Crawl-delay. Запускає завантаження з однієї сторінки на іншу за мінімальний часовий відрізок, що є актуальним для слабких серверів.

Як провести аналіз файлу robots.txt.

Щоб переконатися в правильності створення документа, можна перевірити його на панелі вебмайстра пошукача, використовуючи спеціальне посилання. Згідно з результатами аналізу буде відображено допуск або заборону індексації певних сторінок.

Приклад файлу robot.txt для WordPress та його візуалізація

Версія 1 (не строга)

User-agent: * # Створюємо секцію правил для роботів. * значить для всіх

# роботів. Щоб вказати секцію правил для окремого

# робота, замість * вкажіть ім'я: GoogleBot, Yandex.

Disallow: /cgi-bin # Стандартна папка на хостингу.

Disallow: /? # Усі параметри запиту на головній.

Disallow: *?s= # Пошук.

Disallow: *&s= # Пошук.

Disallow: /search # Пошук.

Disallow: /author/ # Архів автора.

Disallow: */embed$ # Усі вбудовування.

Disallow: */page/ # Усі види пагінації.

Disallow: */xmlrpc.php # Файл WordPress API

Disallow: *utm*= # Посилання з utm-мітками

Disallow: *openstat= # Посилання з позначками openstat

Allow: */wp-*/*.js # всередині /wp- (/*/ - для пріоритету)

Allow: */wp-*/*.css # всередині /wp- (/*/ - для пріоритету)

Allow: */wp-*/*.png # малюнки в плагінах, cache папці і т.д.

Allow: */wp-*/*.jpg # малюнки в плагінах, cache папці і т.д.

Allow: */wp-*/*.jpeg # малюнки в плагінах, cache папці і т.д.

Allow: */wp-*/*.gif # малюнки в плагінах, cache папці і т.д.

Allow: */wp-*/*.svg # малюнки в плагінах, cache папці і т.д.

Allow: */wp-*/*.webp # файли в плагінах, папці cache і т.д.

Allow: */wp-*/*.swf # файли в плагінах, папці cache і т.д.

Allow: */wp-*/*.pdf # файли в плагінах, папці cache і т.д.

# Секція правил закінчена

# Одна чи кілька посилань на карту сайту (файл Sitemap). Це незалежна

# директива та дублювати її для кожного User-agent не потрібно. Так наприклад

# Google XML Sitemap створює 2 карти сайту:

Sitemap: http://example.com/wp-sitemap.xml

Sitemap: http://example.com/wp-sitemap.xml.gz

# Версія коду: 2.0

# Не забудьте змінити `example.com` на ваш сайт.Версія 2 (cтрога)

User-agent: * # Створюємо секцію правил для роботів. * значить для всіх

# роботів. Щоб вказати секцію правил для окремого

# робота, замість * вкажіть ім'я: GoogleBot, Yandex.

Disallow: /cgi-bin # Стандартна папка на хостингу.

Disallow: /wp- # Все пов'язане з WP - це: /wp-content /wp-admin

# /wp-includes /wp-json wp-login.php wp-register.php.

Disallow: /wp/ # Каталог куди встановлено ядро WP (якщо ядро встановлено

# у підкаталог). Якщо WP встановлено стандартно, то

# правило можна видалити.

Disallow: /? # Усі параметри запиту на головній.

Disallow: *?s= # Пошук.

Disallow: *&s= # Пошук.

Disallow: /search # Пошук.

Disallow: /author/ # Архів автора.

Disallow: */embed$ # Усі вбудовування.

Disallow: */page/ # Усі види пагінації.

Disallow: */xmlrpc.php # Файл WordPress API

Disallow: *utm*= # Посилання з utm-мітками

Disallow: *openstat= # Посилання з позначками openstat

Allow: */wp-*/*ajax*.php # AJAX запити: */admin-ajax.php */front-ajaxs.php

Allow: */wp-sitemap # карта сайту (головна та вкладені)

Allow: */uploads # відкриваємо uploads

Allow: */wp-*/*.js # всередині /wp- (/*/ - для пріоритету)

Allow: */wp-*/*.css # всередині /wp- (/*/ - для пріоритету)

Allow: */wp-*/*.png # малюнки в плагінах, cache папці і т.д.

Allow: */wp-*/*.jpg # малюнки в плагінах, cache папці і т.д.

Allow: */wp-*/*.jpeg # малюнки в плагінах, cache папці і т.д.

Allow: */wp-*/*.gif # малюнки в плагінах, cache папці і т.д.

Allow: */wp-*/*.svg # малюнки в плагінах, cache папці і т.д.

Allow: */wp-*/*.webp # файли в плагінах, папці cache і т.д.

Allow: */wp-*/*.swf # файли в плагінах, папці cache і т.д.

Allow: */wp-*/*.pdf # файли в плагінах, папці cache і т.д.

# Секція правил закінчена

# Одна чи кілька посилань на карту сайту (файл Sitemap). Це незалежна

# директива та дублювати її для кожного User-agent не потрібно. Так наприклад

# Google XML Sitemap створює 2 карти сайту:

Sitemap: http://example.com/wp-sitemap.xml

Sitemap: http://example.com/wp-sitemap.xml.gz

# Версія коду: 2.0

# Не забудьте змінити `example.com` на ваш сайт.Цей код я мабуть не рекомендував би, тому що тут закривається все від wp-і потрібно буде описати все що дозволено. Так у майбутньому, коли WP введе щось нове, це може стати недоступним для роботів.